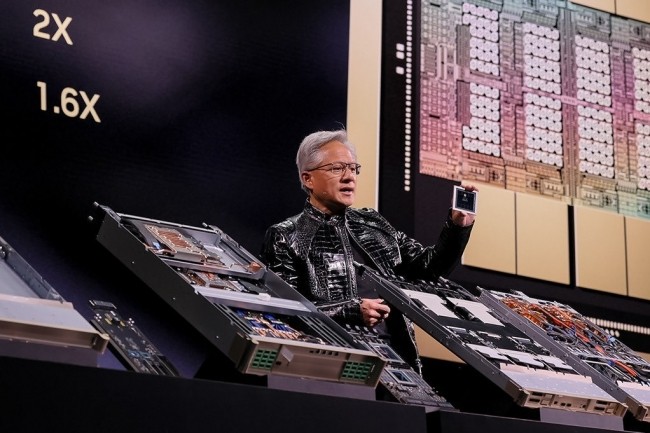

Quelques semaines avant la prochaine GTC (du 16 au 19 mars 2026 au San Jose McEnery Convention Center,) Nvidia a profité de la vitrine du CES 2026 pour présenter en détail sa dernière génération de GPU Rubin, assurant une performance de calcul cinq fois supérieure à celle de Blackwell. Baptisée en hommage à l'astronome Vera Florence Cooper Rubin, cette architecture marque un tournant dans la course à la puissance de calcul pour l'intelligence artificielle. « Vera Rubin est conçue pour relever ce défi fondamental auquel nous sommes confrontés : la quantité de calcul nécessaire pour l'IA monte en flèche », a déclaré le CEO de Nvidia devant une assemblée conquise. L'annonce la plus attendue est tombée après une heure de présentation : « Aujourd'hui, je peux vous dire que Vera Rubin est en pleine production ». Cette déclaration a immédiatement rassuré les investisseurs et les partenaires du géant des semiconducteurs, confirmant que la production de masse a déjà démarré et devrait s'intensifier au second semestre 2026.

Lancé avec un peu d'avance, le GPU Rubin est déjà en fabrication chez les fournisseurs de Nvidia. (Crédit Nvidia)

Des performances améliorées pour l'IA

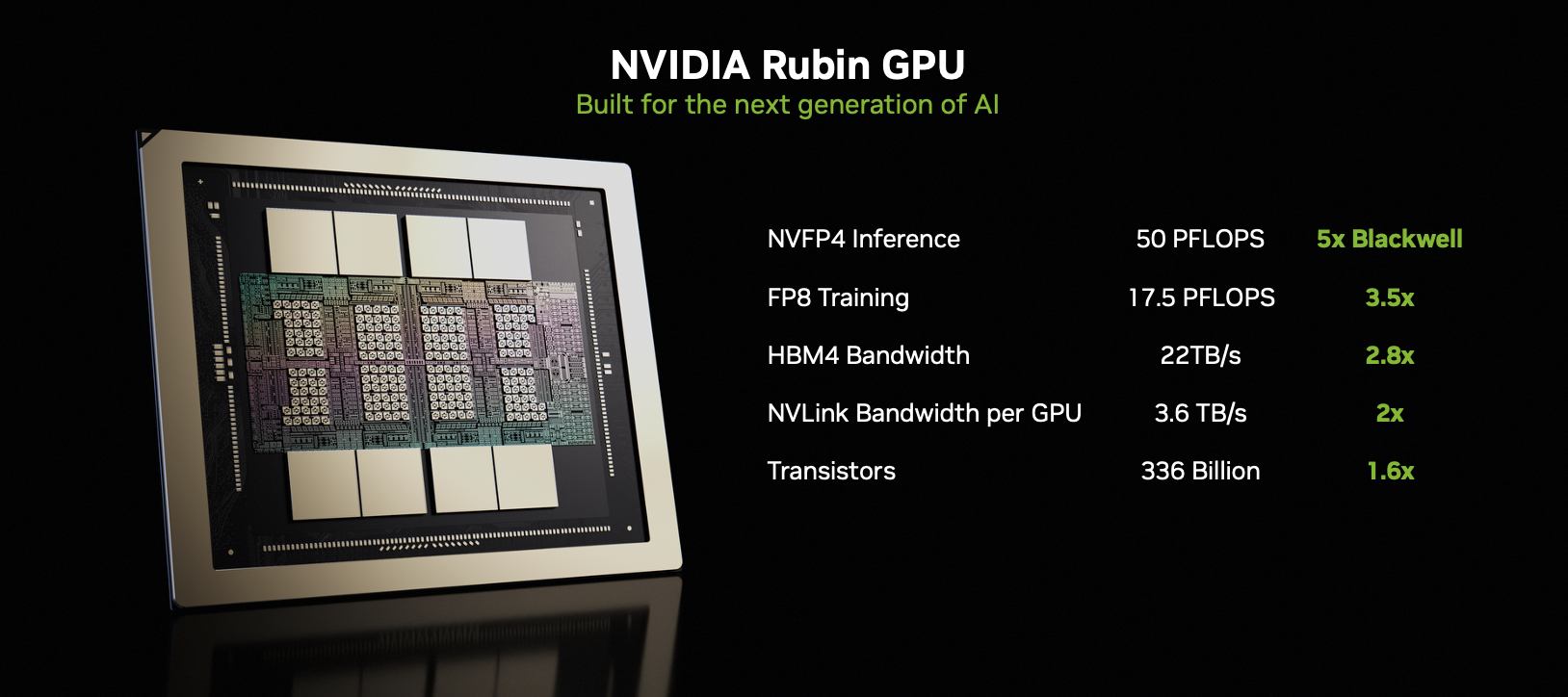

Le GPU Rubin constitue le cœur de cette architecture et affiche des spécifications techniques impressionnantes. Avec ses 336 milliards de transistors, la puce atteint 50 pétaflops de performance lors du traitement de données en NVFP4, soit cinq fois plus que Blackwell pour les tâches d'inférence. Pour l'entraînement de modèles d'IA, Rubin délivre jusqu’à 35 pétaflops en FP4, représentant une amélioration de 250% par rapport à la génération précédente. « Rubin arrive exactement au bon moment, car la demande de calcul IA tant pour l'entraînement que pour l'inférence explose », a souligné Jensen Huang. Cette performance brute s'accompagne d'une efficacité énergétique améliorée : le serveur Vera Rubin NVL72 (détaillé plus bas) supporte huit fois plus de calcul d'inférence par watt consommé, un atout crucial dans un contexte où les centres de données cherchent à réduire leur empreinte énergétique.

Pour accompagner son GPU Rubin, et se passer des puces Intel ou AMD, Nvidia commercialise aussi son CPU Vera. (Crédit Nvidia)

Six puces pour équiper le serveur NVL72

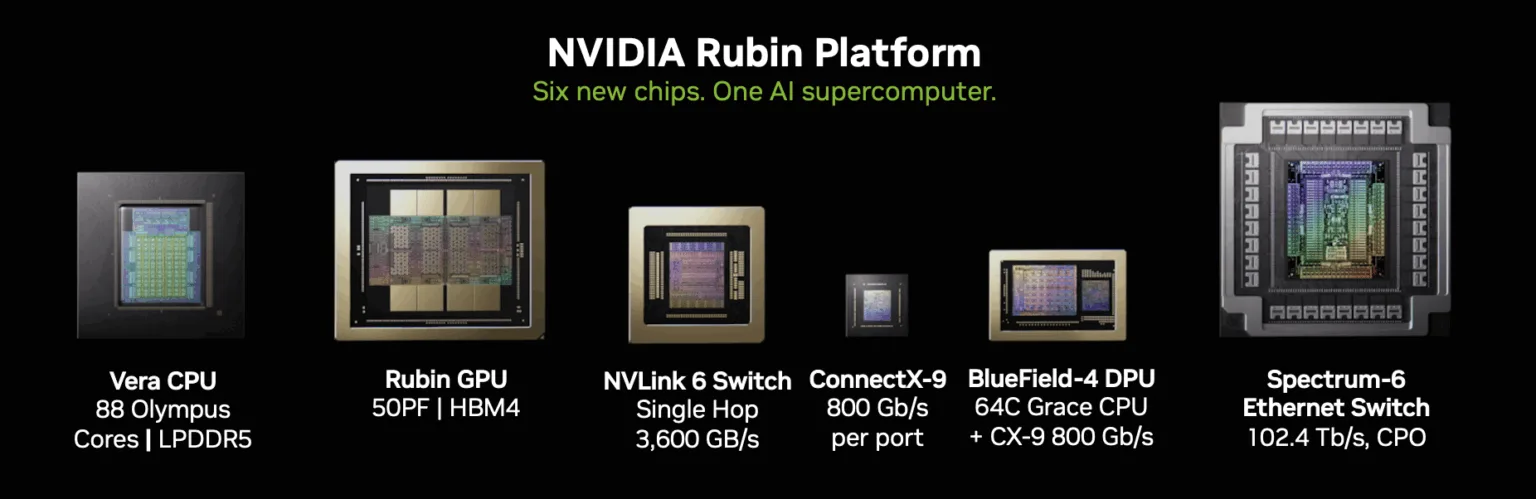

Le GPU Rubin intègre jusqu'à 288 Go de mémoire HBM4 par puce, avec une bande passante agrégée atteignant 22 To/s, soit 2,8 fois plus rapide que la génération Blackwell Ultra. Cette mémoire de dernière génération, qui n'était même pas encore commercialisée lors de l'annonce initiale de Rubin en 2024, permet de soutenir l'inférence à contexte long, l'exécution de modèles MoE à lots élevés et le raisonnement interactif sans sacrifier la concurrence ou l'utilisation. Comme Grace et Blackwell hier, l'architecture associant aujourd’hui les CPU Vera et les GPU Rubin repose sur une approche d'extrême co-conception impliquant six puces distinctes travaillant en parfaite harmonie. Aux côtés du GPU Rubin, Nvidia déploie donc le CPU Vera, doté de 88 cœurs personnalisés Olympus – sur base Armv9.2 - optimisés pour les usines IA. Arrive ensuite le switch NVLink 6, sixième génération du protocole d'interconnexion à l'échelle du rack, offre une bande passante GPU-à-GPU de 3,6 To/s, permettant aux multiples circuits graphiques de coordonner leurs tâches lors de l'exécution de modèles d'IA distribués. Cette interconnexion ultrarapide constitue l'épine dorsale des systèmes massivement parallèles nécessaires aux charges de travail IA.

Autour du GPU Rubin, Nvidia dégaine les composants Vera, NVLink-6, ConnectX-9, BlueField-4 et Spectrum-6 pour configurer un serveur NVL72. (Crédit Nvidia)

On trouve également ConnectX-9, la dernière génération de smartNIC maison offrant une interface réseau - Ethernet ou Infiniband - à haut débit et faible latence pour les serveurs IA. Cette carte décharge les tâches réseau traditionnellement effectuées par le CPU principal, libérant ainsi davantage de capacité de traitement pour les charges de travail d'IA. Le BlueField-4, unité de traitement de données (DPU), se présente comme un package à double matrice combinant un CPU Grace à 64 cœurs pour épauler le réseau et la sécurité, ainsi qu'une puce réseau intégrée ConnectX-9 pour un mouvement de données étroitement couplé. Cette DPU alimente également la plateforme de stockage Inference Context Memory Storage, conçue pour optimiser le cache clé-valeur des grands modèles de langage. Lorsqu'un LLM effectue des calculs récurrents, ce cache permet de sauvegarder les résultats et de les réutiliser plutôt que de recalculer à chaque fois, améliorant considérablement l'efficacité matérielle. Enfin, le commutateur Ethernet Spectrum-6 assure la connectivité d'extension entre racks utilisant de l'optique co-packagée pour l'efficacité et la fiabilité. Fonctionnant en tandem avec NVLink 6, il permet de créer des superordinateurs d'IA à l'échelle du datacenter.

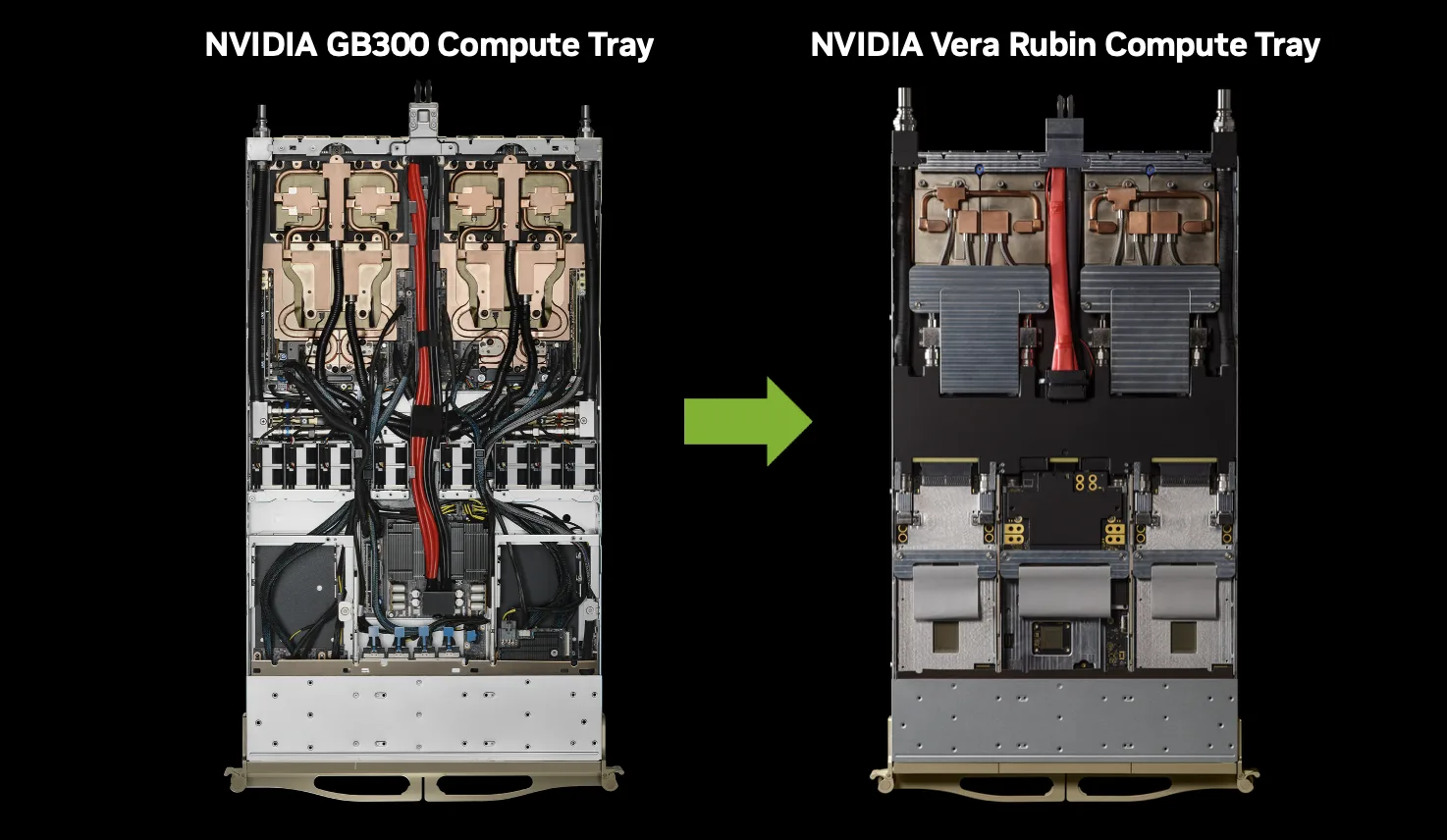

Avec l'arrivée de Rubin, Nvidia a profondément revu le design de ses châssis serveurs pour optimiser le refroidissement et maitriser la consommation énergétique. (Crédit Nvidia)

Vera Rubin NVL72 : une centrale de calcul

Ces six puces s'assemblent dans le serveur Vera Rubin NVL72, véritable monstre de calcul destiné aux centres de données. Cette appliance intègre 72 GPU Rubin et 36 CPU Vera répartis sur 18 modules de calcul dans un design sans câble qui réduit les temps d'assemblage et de maintenance d'un facteur de 18 par rapport aux systèmes basés sur Blackwell. Le NVL72 embarque au total 220 000 milliards de transistors et offre une bande passante de 260 térabits par seconde. Le système dispose de 20,7 To de mémoire HBM4 pour les GPU et de 54 To de LPDDR5x pour les CPU. Un moteur RAS amélioré assure la tolérance aux pannes et effectue des vérifications de santé en temps réel pour garantir le bon fonctionnement du matériel. Nvidia propose également une version plus compacte, le DGX Rubin NVL8, équipé de huit GPU Rubin au lieu de 72. Ces deux systèmes constituent la base de la nouvelle architecture de référence DGX SuperPOD pour la construction de clusters d'IA, accompagnée de la plateforme logicielle Mission Control pour la gestion de l'infrastructure. Les systèmes basés sur Rubin ont déjà été réservés par la quasi-totalité des principaux fournisseurs cloud, notamment dans le cadre de partenariats avec Anthropic, OpenAI et Amazon Web Services. Ils équiperont également le superordinateur Blue Lion de HPE et le futur superordinateur Doudna du Lawrence Berkeley National Lab. Les premières livraisons sont attendues au second semestre 2026, marquant une nouvelle étape dans la course à la suprématie de l'IA.

Commentaire